OpenAI n'interdit plus l'utilisation militaire de ses technologies comme ChatGPT

Dans la version la plus récente de sa politique d'utilisation, OpenAI n'inclut plus la clause qui restreignait expressément l'utilisation de ses technologies à des fins de guerre ou militaires. Auparavant, le règlement de l'entreprise interdisait clairement l'utilisation de ses produits dans le domaine militaire.

De même, il a éliminé l'article qui mentionnait son utilisation dans la "gestion ou l'exploitation d'infrastructures critiques en matière d'énergie, de transport et d'eau".

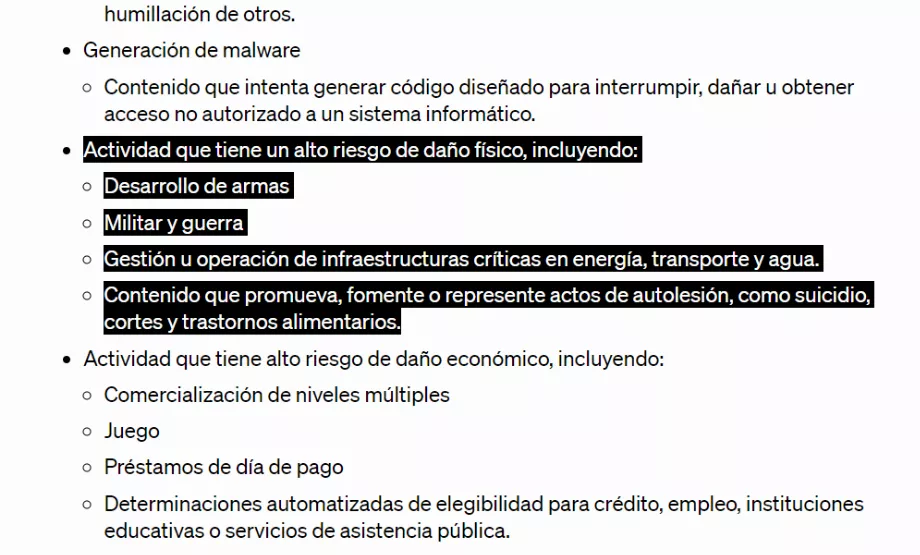

Dans la version précédente de ses politiques d’utilisation, il indiquait :

« Utilisation interdite de nos modèles. Nous n'autorisons pas l'utilisation de nos modèles pour les activités suivantes : Activités présentant un risque élevé de dommages physiques, notamment : - Développement d'armes - Militaire et guerre - Gestion ou exploitation d'infrastructures critiques dans les domaines de l'énergie, des transports et de l'eau. - Contenu qui promeut, encourage ou décrit des actes d'automutilation, tels que le suicide, les coupures et les troubles de l'alimentation.

Alors que, dans les politiques actuelles du 10 janvier 2024, sur le site Internet de l'entreprise, on dit :

« N'utilisez pas notre service pour vous faire du mal ou faire du mal à autrui ; Par exemple, n'utilisez pas nos services pour promouvoir le suicide ou l'automutilation, développer ou utiliser des armes, blesser autrui ou détruire des biens, ou vous engager dans des activités non autorisées qui violent la sécurité de tout service ou système.

Le changement dans la politique d'utilisation d' OpenAI a été initialement détecté par The Intercept, qui a contacté l'entreprise pour plus de détails.

Un représentant d' OpenAI , Niko Felix , a répondu par courrier électronique au média susmentionné, précisant que l'objectif de l'entreprise "était de créer un ensemble de principes universels faciles à retenir et à appliquer, d'autant plus que nos outils sont désormais utilisés à l'échelle mondiale". les utilisateurs qui peuvent désormais également créer GPT ».

Il a ensuite expliqué l'intention de l'entreprise : « un principe tel que « Ne pas nuire à autrui » est vaste mais facile à comprendre et pertinent dans de nombreux contextes. » Félix a également noté : « De plus, nous citons spécifiquement les armes et les blessures infligées à autrui comme exemples clairs. »

Felix a également écrit dans cet e-mail que "toute utilisation de notre technologie, y compris par l'armée, pour développer ou utiliser des armes, blesser autrui ou détruire des biens, ou se livrer à des activités non autorisées qui violent la sécurité de tout service ou système", est pas autorisé ».

Heidy Khlaaf , directrice de l'ingénierie de la société de cybersécurité Trail of Bits et spécialiste de l'apprentissage automatique et de la sécurité des systèmes autonomes, a exprimé aux médias son inquiétude quant aux risques et dommages potentiels qui pourraient découler de l'utilisation de la technologie et d'OpenAI . services dans des contextes militaires.

Khlaaf a fait référence à un article de 2022, dans lequel il a collaboré avec des chercheurs d' OpenAI , soulignant spécifiquement le danger de son utilisation dans des applications militaires. Elle a noté un changement dans la politique de l’entreprise, qui, selon elle, donne la priorité à la légalité plutôt qu’à la sécurité.

Selon l'expert, "il y a une nette différence entre les deux politiques, puisque la première décrit clairement que le développement des armes, de l'armée et de la guerre ne sont pas autorisés, tandis que la seconde met l'accent sur la flexibilité et le respect de la loi".

Il a souligné que, puisque le développement d’armes et les activités de guerre peuvent être légaux, cela ne diminue en rien les conséquences potentiellement graves de l’intelligence artificielle sur la sécurité.

Il a souligné les inquiétudes concernant les biais et les erreurs des modèles linguistiques à grande échelle et a averti que leur application dans des contextes de guerre pourrait entraîner des opérations imprécises et biaisées avec une éventuelle augmentation des dégâts et des pertes civiles.

Comment activer le mode football sur une Smart TV pour regarder la Copa América

Avec l'effervescence de la Copa América, plusieurs fans recherchent la meilleure façon de regarder les matchs sur leur Smart TV. L’une des meilleures alternatives est le mode football ou le mode sport.

Modern Family est la vedette d'une publicité WhatsApp destinée aux familles équipées d'iPhone et d'Android

WhatsApp a réuni une partie du casting de Modern Family pour jouer dans une nouvelle publicité axée sur la promotion de groupes entre familles utilisant à la fois des appareils iPhone et Android.

Glossaire technologique : quels types d'innovation existe-t-il

Au cours des dernières décennies, la technologie est non seulement devenue un outil de base, mais elle fait également partie de notre vie quotidienne, au point qu’il est presque impossible d’imaginer ce que serait d’accomplir des tâches sans elle.

Tether : quel est le prix de cette cryptomonnaie ce 19 juin

Tether, la cryptomonnaie de type stablecoin qui prétend que chacun de ses tokens est adossé à un dollar américain, est émise par la société Tether Limited et depuis ses origines a été impliquée dans diverses controverses.

Comment personnaliser WhatsApp avec le mode cœur noir

Pour les utilisateurs de WhatsApp souhaitant personnaliser leur expérience, l’activation du « mode cœur noir » est une excellente option. Ce mode remplace l’icône d’appel téléphonique standard (qui est généralement blanche) par l’emoji cœur noir.